L’Observatoire EVAPM, une aventure de l’APMEP

Les évaluations nationales, de CP, de Seconde…, ont fait couler beaucoup d’encre cette année. C’est l’occasion de rappeler le rôle de pionnière qu’a joué l’APMEP dans la réflexion sur l’évaluation et la mise en œuvre de pratiques concertées avec les enseignants, et de (re)mettre en avant les valeurs que notre association défend, en ce qui concerne ces questions hautement politiques.

Antoine Bodin

© APMEP Septembre 2019

⋅⋅⋅⋅⋅⋅⋅⋅⋅⋅♦⋅⋅⋅⋅⋅⋅⋅⋅⋅⋅

Bref historique de l’évaluation des acquis des élèves en France

Avant les années 1980, le terme « évaluation » était rarement utilisé dans le champ de l’éducation ; toute l’attention était alors portée sur les notes, les examens et les classements et s’appuyait essentiellement sur le jugement des enseignants.

Il faudrait un long article pour expliquer pourquoi et comment, à partir de la fin des années 1970, la question de l’évaluation a peu à peu envahi le domaine de l’éducation, en même temps que les autres champs de la société (santé, politiques sociales, etc.).

Passer de la notation à l’évaluation, même partiellement comme c’est toujours le cas, procède d’un changement profond dans les conceptions des rapports entre l’école et la société, entre les institutions (non réduites à l’Éducation Nationale) et l’école, ainsi qu’entre les enseignants, les élèves et les familles.

Ce n’est qu’en 1989 que le terme évaluation apparaît dans les textes officiels régissant l’Éducation Nationale. Il s’agit alors de l’évaluation individuelle des élèves, mais aussi de l’évaluation globale des acquis des élèves.

Les années 1960 marquent le début des études internationales, d’abord pilotées par l’UNESCO. Elles placent déjà en priorité les mathématiques. Bien que le terme d’évaluation ne soit pas encore utilisé, il s’agit bien d’évaluer les acquis des élèves pour permettre des comparaisons entre pays et pour informer les politiques éducatives des pays participants. Vingt ans plus tard, la France met en place ses propres évaluations des acquis des élèves.

« Le développement des évaluations standardisées apparaît en effet, aux yeux des responsables des services statistiques, s’appuyant sur les exemples étrangers et internationaux, comme un complément indispensable des statistiques pour rendre compte du système et le piloter. » [1]

Ces évaluations sur échantillons sont peu ou pas connues des enseignants. Elles ne font pas les grands titres de la presse, sont peu prises en compte par les corps intermédiaires et ont une influence limitée sur l’évolution des programmes.

Un premier changement s’opère en 1989 avec l’arrivée des évaluations de masse (évaluation dites « Jospin »). Ceci est une autre histoire qui mériterait aussi d’être racontée.

La création d’EVAPM

À la rentrée 1978, signe des temps, une commission nationale Évaluation était créée à l’APMEP. Cette commission, très active, s’est d’abord intéressée aux questions de notation (docimologie) pour peu à peu s’intéresser à l’évaluation dans son sens actuel. C’est cette commission qui a donné naissance à EVAPM.

En 1986, suite aux travaux de la COPREM1, un nouveau programme de mathématiques est mis en place pour le premier cycle. Ce programme décrivait en particulier les « compétences exigibles », de façon assez ambiguë dans la mesure où rien n’était prévu pour le cas où ce qui était décrit comme exigible ne serait pas atteint par un élève particulier ou par une sous-population d’élèves. Quoi qu’il en soit, les enseignants ont vu là, sinon une obligation de réussite, du moins la nécessité de contrôler de plus près la possible adéquation entre ces exigibles et la réalité des savoirs acquis par les élèves. Une situation inédite.

Coïncidence ou indifférence ? 1986 a aussi vu la disparition momentanée des évaluations nationales sur échantillon, lesquelles, peu connues des enseignants comme on l’a vu, fournissaient au moins quelques indicateurs de cette réalité.

Le bureau de l’APMEP et les commissions nationales Premier Cycle et Évaluation s’étaient depuis plusieurs années mobilisées autour du travail de la COPREM et des nouveaux programmes. À défaut de l’expérimentation préalable souhaitée par certains, s’était dégagée la volonté de suivre et d’évaluer ces programmes au fur et à mesure de leur mise en place. Sous l’impulsion de Marie-José Houssin, secrétaire nationale premier cycle, il a alors été décidé, dès la fin du premier trimestre 1986-1987 de mettre en place un programme d’évaluation indépendant. EVAPM, pour Évaluation des Programmes de Mathématiques, était né, un peu comme une tentative de pallier ce qui nous paraissait être une carence de l’institution.

Mise en œuvre et évolutions

Dès ce moment, l’opérationnalisation des « compétences exigibles » du niveau 6e a été faite : huit épreuves ont été construites dont quatre portaient sur les compétences exigibles, les quatre autres portant sur des compétences d’approfondissement (il nous paraissait en effet important de ne pas nous limiter et de ne pas risquer de limiter la formation des élèves à ces fameux exigibles). Sur le modèle des études internationales, nous avons utilisé un plan d’évaluation croisé qui consistait à ne faire passer à chaque élève que deux épreuves tout en recueillant pratiquement la même information que si l’on avait fait passer les huit épreuves à tous les élèves (en tout près de 200 questions et 400 items d’information).

Bien évidemment, compte tenu du statut de l’APMEP, l’évaluation s’est déroulée sur la base du volontariat des enseignants (mais non des élèves), et de façon indépendante de la hiérarchie. Cela s’est poursuivi de même au cours des années. Toutefois, nous avions obtenu l’accord de l’Inspection Générale et de la DLC (ancienne DGESCO)2, ce qui nous a facilité l’accès aux collèges et la bienveillance des chefs d’établissements. Les facilités apportées par Internet n’ont pu être utilisées qu’à partir de 2003. Jusqu’à cette date, tout est passé par la Poste : les enseignants recevaient l’ensemble des documents nécessaires à l’évaluation, ce qui supposait des frais importants d’impression, de manipulation et d’affranchissement3.

En règle générale, les épreuves étaient passées au cours du mois de mai et les résultats étaient disponibles à la rentrée suivante. Les analyses demandant un peu de temps, les brochures contenant les analyses étaient diffusées et envoyées quelques mois plus tard à tous les professeurs ayant participé à l’évaluation.

L’Observatoire et ses objectifs

EVAPM a donc d’abord été conçu comme un dispositif d’évaluation des programmes de mathématiques, ou plutôt du curriculum mathématique. Nous nous intéressions en effet non seulement aux acquis des élèves mais aussi aux conditions d’enseignement et aux avis des enseignants.

Nous avons rapidement décidé de poursuivre au-delà de la classe de Sixième, tout en répliquant ou complétant ces évaluations à intervalles plus ou moins réguliers. D’où le nom d’Observatoire que nous avons donné au dispositif ainsi construit.

Ainsi, dix-neuf opérations ont été menées, de la Sixième aux classes Terminales incluses (toutes séries), en passant par le niveau Terminale BEP en lycée professionnel (LP).

| Les opérations EVAPM de 1987 à 2008 | |||||||||||||

| 1987 | Sixième | 1992 | Troisième | 1997 | Sixième | 2002 | 2007 | ||||||

| 1988 | Cinquième | 1993 | Premières | 1998 | 2003 | Seconde | 2008 | Sixième Cinquième |

|||||

| 1989 | Sixième Quatrième |

1994 | 1999 | Terminales LEGT |

2004 | ||||||||

| 1990 | Cinquième Troisième |

1995 | Terminales LP |

2000 | Premières | 2005 | Sixième Première S |

||||||

| 1991 | Quatrième Seconde |

1996 | 2001 | 2006 | |||||||||

Peu à peu, les objectifs de l’Observatoire se sont diversifiés et peuvent se résumer ainsi :

-

constituer une force réactive capable de répondre aux besoins des instances de l’APMEP, c’est-à-dire être capable de fournir à la demande des notes techniques et de synthèse sur des questions d’actualité ;

-

associer fortement les enseignants à la préparation et à l’exploitation des enquêtes. Cet objectif était implicite au début d’EVAPM mais a été fortement réaffirmé et opérationnalisé ;

-

apporter aux enseignants des indicateurs sur les comportements d’élèves (évaluation) et des instruments d’observation de ces comportements ;

-

contribuer à l’animation des équipes d’établissement, à l’auto-formation des enseignants, ainsi qu’à leur formation initiale et continue ;

-

mettre à la disposition des personnes et institutions intéressées par l’enseignement des mathématiques, des informations s’appuyant sur des observations fiables (ou du moins dont la fiabilité serait systématiquement soumise à examen) ;

-

mettre à la disposition des enseignants des instruments d’évaluation validés et étalonnés dans un cadre coordonné permettant des interactions entre enseignants et équipes d’enseignants ;

-

expérimenter et diffuser des conceptions développées (en particulier) à l’APMEP sur l’enseignement des mathématiques et sur l’évaluation ;

-

permettre aux chercheurs d’avoir accès à des sous-populations ou à des échantillons importants (d’enseignants, d’élèves…) ;

-

constituer un lieu d’échanges entre praticiens et chercheurs, permettant en particulier aux questions des enseignants d’être mieux prises en compte par les chercheurs. L’Observatoire devait constituer un moyen d’articulation de la recherche et de la pratique sans pour autant conduire à la confusion des problématiques.

Nous pensions ainsi EVAPM comme un vaste chantier d’ingénierie didactique, au double sens que Michèle Artigue donnait alors à cette expression, c’est-à-dire qu’il pourrait tout à la fois « conduire à des productions réalisées pour l’enseignement et s’appuyant sur des recherches, et contribuer à produire des méthodologies de recherche. » (Artigue 1990).

L‘image ci-dessous résume à la fois les ambitions et les réalisations d’EVAPM :

Un exemple

Illustrons les points 2 et 3 ci-dessus.

Pour une étude donnée, par exemple EVAPM Seconde 1991, une analyse approfondie des programmes était faite par l’équipe EVAPM en coordination avec la commission nationale concernée. Rappelons ici qu’il s’agissait d’évaluer les programmes. L’équipe, une vingtaine de collègues, se réunissait trois fois dans l’année pour élaborer une table de spécification (outil destiné à assurer une couverture satisfaisante des objectifs du programme). Suivaient la rédaction des questions d’évaluation, la mise au point des questionnaires et des consignes de passation. Cette mise au point intégrait une expérimentation des questions par des collègues volontaires, non nécessairement membres de l’équipe.

Un courrier était envoyé aux coordonnateurs mathématiques de tous les établissements du pays et un dialogue s’engageait : les collègues pouvant proposer des questions, demander des explications supplémentaires… dans ces temps déjà lointains, il n’était pas question de l’internet et tout se faisait par voie postale et par téléphone.

2 000 professeurs ont participé à cette étude, ce qui représente 90 000 élèves dans 2 500 classes. L’étude comportait 15 questionnaires : environ 300 questions pour plus de 600 prises d’information.

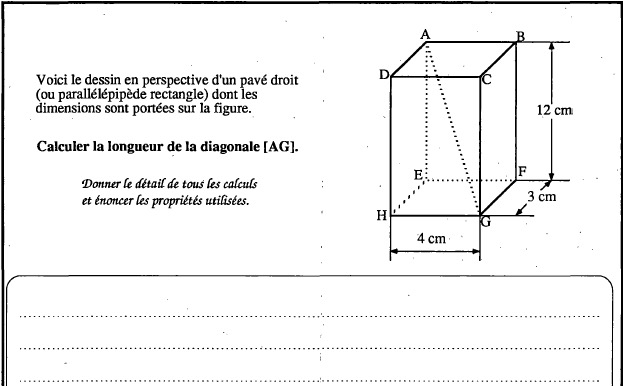

Voici l’une de ces questions ; elle opérationnalisait le point suivant du programme :

« Savoir utiliser dans des situations simples concernant des solides, le théorème de Pythagore pour des calculs de longueurs. — diagonale d’un parallélépipède rectangle… »

Et voici l’analyse que nous en faisions4.

« La question, déjà posée en Quatrième et en Troisième (en 1989 et 1990) a eu… en Seconde, une amélioration sensible dans son taux de réussite, par rapport aux résultats des années antérieures.

… [en 1990] 61 % des élèves de Troisième admis en Seconde avaient réussi cette question [elle avait été réussie par 21 % des élèves en Quatrième et par 48 % de l’ensemble des élèves en Troisième]… en Seconde [1991] pratiquement trois élèves sur quatre arrivent au bout et donnent la réponse exacte. Dans ces mêmes conditions, on peut remarquer que 82 % des élèves contre 67 % en Troisième identifient cette fois un triangle rectangle permettant de résoudre le problème ; 84 % énoncent correctement la relation de Pythagore contre 61 % en Troisième. La reconnaissance de la configuration de Pythagore, dans une situation de l’espace, semble donc acquise et disponible chez les élèves. Seuls 9 % des élèves n’ont pas traité la question. L’habitude de se ramener à des sections planes pour calculer semble bien assimilée en fin de Seconde. »

Un engagement militant pour un projet ambitieux

Au cours de ces vingt-trois années, l’APMEP s’est largement investie dans ce plan d’une ampleur inédite, en mobilisant certes une partie de ses moyens, mais surtout de sa force militante. De 1986 à 2009, de nombreux collègues ont donc été associés à ce que j’appellerai ici l’« aventure » EVAPM. Et il est peu de dire que c’en fut réellement une, à la fois sur le plan humain et sur le plan militant : nous avons avancé sans plan bien défini, saisissant des opportunités et des demandes, sans compter notre temps ni notre engagement.

Au fil des années, nous avons été plus de 80 collègues à avoir directement participé à la conception et aux analyses des 19 études menées dans ce cadre. Au-delà, ce sont plusieurs milliers d’enseignants qui ont fait passer les épreuves dans leurs classes, codé et retourné les résultats, mais aussi contribué d’une façon ou d’une autre aux analyses. Disons aussi que l’aventure en question a largement bénéficié des apports de l’INRP5, des IREM de Franche-Comté et de Poitiers, du Groupe de Recherche Didactique du CNRS (Gérard Vergnaud et al.) ainsi que des bons rapports entretenus avec une partie de l’institution (Inspection générale, DEP6, …).

Les premières années, tout s’est fait de façon militante c’est-à-dire totalement bénévole. Plus tard des moyens attribués par les différentes structures évoquées ci-dessus ont permis d’attribuer quelques heures à certains membres de l’équipe technique. Cela a eu des avantages en termes de continuité et d’efficacité ; en revanche, cela a peut-être eu tendance à gommer le caractère militant de l’aventure.

Pour bien comprendre l’état d’esprit qui nous a animés tout au long de l’aventure, voici ce que nous écrivions à l’aube du siècle :

« Ces objectifs [de l’Observatoire EVAPM] constituent le fil directeur d’un projet ambitieux qui, bon an, mal an, fonctionne depuis plus de quinze ans. La question de la permanence et de la continuité de l’action est inscrite dans ces objectifs et sera sans doute le point le plus difficile à tenir. EVAPM a fonctionné certes, mais toujours à la limite de rupture. Le projet demande en effet la contribution, l’engagement, ou l’appui de nombreux acteurs : enseignants, chercheurs, chefs d’établissements et membres des corps d’inspection. La tentation serait grande de se satisfaire des succès obtenus et de passer à autre chose. Ce n’est pas dans la logique de l’Observatoire. Par exemple, EVAPM a permis des comparaisons intéressantes entre les acquis observés en fin de Sixième en 1997 et ceux observés dans les mêmes conditions en 1987. De même, entre les résultats observés en fin de Seconde en 2003 et ceux observés en 1991. Nous avons la faiblesse de croire que les possibilités de telles comparaisons continueront à intéresser les collègues “qui entreront dans la carrière quand leurs aînés n’y seront plus” (on peut penser à EVAPM Sixième 2007, Seconde 2014 !). »

L’aventure EVAPM a donc connu des hauts et des bas et a été accompagnée d’engouements et de succès, mais aussi de méfiance, tant l’évaluation externe a de quoi inquiéter les enseignants, et tant une évaluation indépendante de l’institution a de quoi inquiéter cette dernière7. C’est ce dernier point qui nous semble important et que je vais maintenant développer.

Éléments de réflexion sur les évaluations

Après ces quinze ans, l’Observatoire a continué à fonctionner, mais de façon ralentie. Les raisons en sont multiples et difficiles à analyser. La place et le rôle que l’institution a peu à peu donnés à l’évaluation me semblent avoir constitué un facteur déterminant de ce ralentissement.

L’évaluation est un miroir porté sur un objet. Selon l’angle de vue, on observera des choses différentes et parfois contradictoires. Or il ne s’agit pas de parvenir à une vue unifiée mais de permettre la confrontation des regards. Dit autrement, les enseignants avec ou sans EVAPM ont leur part de vérité qu’il faut déjà prendre en compte. Avec EVAPM, ils peuvent disposer d’une « vérité» opposable à d’autres et on ne peut plus dire qu’ils restent enfermés dans leur subjectivité tandis que d’autres produiraient une « mesure» de nature irréfutable.

EVAPM ne s’est donc pas construite en opposition avec les évaluations nationales ou internationales. Nous pensions, et pensons toujours, que l’évaluation du curriculum doit être multiple, ouverte, concertée, transparente et contradictoire. Nous avons simplement montré que les enseignants de mathématiques étaient capables de s’organiser et de produire leur propre évaluation, cela d’une façon, répétons-le, indépendante, mais sans être exclusive et sans prétention d’exhaustivité. L’évaluation institutionnelle nous paraît à la fois légitime et nécessaire. Actuellement, la DEPP est devenue particulièrement crédible. La seule chose que l’on puisse lui reprocher est l’opacité qui a longtemps prévalu autour de ses études (qui, à sa décharge n’étaient pas faites pour les enseignants), et sa soumission imposée au Cabinet du Ministre.

Les évaluations internationales (PISA et TIMSS en ce qui nous concerne) sont conduites en France par la DEPP avec un raffinement de méthodologies que nous n’avons pu qu’approcher avec EVAPM. Là encore une grande opacité règne, peu de questions sont libérées et les enseignants reçoivent surtout en retour des images négatives de leurs efforts, relayées à plaisir par les médias.

Mais à quoi cela sert-il à un enseignant d’apprendre que X % des élèves du pays ne maîtrisent pas telle compétence s’il ne sait rien des questions qui ont été posées aux élèves ou s’il ne connaît que la place où se situe son pays sur une échelle dont quasiment personne ne sait comment elle a été construite ?

Pour être justes, nous devons dire que les choses ont un peu changé ces dernières années avec les évaluations CEDRE de la DEPP. Ces dernières sont davantage conçues pour aider les enseignants ; les rapports publiés sont bien construits et contiennent de nombreux items qui permettent de comprendre ce qui est en jeu. Ils sont facilement accessibles sur l’internet ![]() mais il n’est pas certain que les enseignants aient le temps ni le réflexe de s’y plonger. Il manque peut-être un accompagnement en formation (mais cela est un autre sujet sensible).

mais il n’est pas certain que les enseignants aient le temps ni le réflexe de s’y plonger. Il manque peut-être un accompagnement en formation (mais cela est un autre sujet sensible).

Pour revenir à qui me semble être la cause principale d’une certaine lassitude des enseignants devant l’évaluation externe, j’identifierais ici une faute initiale de l’institution : en 1989, donc peu après les débuts d’EVAPM, l’évaluation de début de Sixième a été imposée à tous. Il y a bien eu quelques réticences, quelques refus de participer, mais peu à peu beaucoup d’enseignants ont admis que cette évaluation n’était pas faite contre eux mais avec eux et qu’ils pouvaient en tirer profit pour leurs élèves. Cette évaluation était en effet totalement ouverte et les résultats ne devaient être remontés qu’au niveau local, sans qu’il soit question de s’en servir pour classer les établissements, et encore moins pour évaluer les enseignants. La confiance s’est peu à peu installée8.

Mais voilà, l’administration a voulu transformer ce bel ouvrage en couteau suisse. Puisqu’on avait des données, autant s’en servir dans de multiples directions : évaluer les acquis individuels des élèves (qui n’étaient d’ailleurs que des pré-acquis de début d’année), évaluer les établissements, les classer, classer les académies, et finalement produire des indicateurs internationaux sur le fonctionnement de l’école française.

Peu à peu les enseignants se sont sentis trahis, d’autant que quelques années plus tard, on a tenté de faire jouer à des évaluations semblables un rôle dans l’évaluation des enseignants.

Pourtant, la recherche avait montré depuis longtemps que vouloir confier des rôles différents à une même évaluation, c’était le plus souvent la condamner.

En ce qui concerne les évaluations officielles, un premier sommet a été atteint en 2009. Dans le BGV 144 de juillet 2009, j’écrivais :

« L’évaluation CM2 de janvier 2009 restera-t-elle dans les annales comme un de ces loupés notables provoqués par le fonctionnement aveugle d’une administration sûre d’elle et inapte à traiter les enseignants comme des professionnels responsables ? Ce qui marque cette évaluation est en effet le mépris dans lequel sont tenus les enseignants, mais aussi les cadres intermédiaires, mais aussi leurs organisations représentatives (telle que l’APMEP) et syndicales. »

Pour tout dire, il y a fort à craindre qu’un nouveau sommet soit atteint en ce moment ! On pourra s’étonner que, voulant parler d’EVAPM, on en profite pour faire la critique de la façon dont l’évaluation est comprise et utilisée par l’institution. Pourtant, alors qu’EVAPM s’est efforcé de contribuer au développement d’une culture de l’évaluation au service des apprentissages, nous avons la conviction que certaines actions d’origine ministérielle viennent saper cette culture au lieu de la conforter.

Les apports d’EVAPM

On nous demande souvent ce que l’Observatoire EVAPM nous a appris… Bien sûr, et c’était l’objectif premier, il nous a fourni un grand nombre d’indicateurs sur les acquis des élèves par rapport aux connaissances et aux compétences définies par les programmes et nous a permis de suivre ces indicateurs dans le temps. Il nous a par ailleurs largement confirmés dans l’idée que l’évaluation n’était pas une opération sans risque, qu’il ne suffisait pas de définir en quelques mots des compétences, exigibles ou non, pour que la production d’outils permettant de vérifier leur acquisition soit évidente. Que la production de quelques questions d’évaluation dans le but de les vérifier était une opération pour le moins hasardeuse. Nous avons le sentiment d’avoir pas mal progressé sur ces questions mais nous pensons qu’il est possible et souhaitable d’aller plus loin. Des méthodes de traitement des données telle que l’analyse implicative et l’IRT (analyse des réponses aux items), méthode utilisée dans les évaluations internationales, ont été expérimentées avec profit mais beaucoup reste à faire. Il n’est pas question de suggérer que tous les enseignants devraient devenir des experts de ce que l’on appelle aujourd’hui l’édumétrie, mais de suggérer qu’il ne serait pas sain de laisser ces techniques aux seules mains de spécialistes étrangers à notre communauté.

Signalons ici que le terme compétence utilisé dans les programmes de 1986 était plutôt mal choisi. Outre que ce n’est pas le sens qu’on lui donne aujourd’hui dans le cadre des programmes nationaux comme internationaux, ce n’était pas non plus le sens que l’APMEP lui donnait depuis plusieurs années. Sous l’impulsion d’Henri Bareil, EVAPM, malgré les difficultés que cela amenait, a toujours essayé d’aller au-delà des connaissances sans objet pour aller vers des situations riches mettant en jeu les différents aspects des compétences telles qu’elles sont pensées aujourd’hui. Simultanément, nous pensions, et pensons toujours, qu’il n’y a pas de compétences sans connaissances, et que la seule fixation sur des situations plus ou moins complexes supposées être de nature à révéler les compétences ne suffisait pas à contrôler les connaissances. Bref, nous n’avons jamais hésité à poser des questions portant simplement sur une connaissance particulière lorsque c’était cette connaissance que nous voulions contrôler.

L’Observatoire nous a encore beaucoup appris sur les difficultés des élèves, sur la volatilité des connaissances. Il nous a montré à quel point des connaissances acquises au cours d’une année donnée s’effaçaient au cours des années suivantes si elles n’étaient pas entretenues. Il nous semble que cela constitue l’une des raisons des résultats bien médiocres obtenus par notre pays dans l’évaluation PISA.

Cela ne faisait pas partie des objectifs, mais au tournant de l’année 2000, EVAPM a dû confirmer une baisse significative importante des acquis des élèves. Par souci de ne présenter que des données objectives, nous avons longtemps laissé à d’autres le soin d’interpréter nos données, mais la note « Alerte aux maths ? » publiée dans le BGV 123 a lancé l’alarme. La place attribuée à cet article ne permet pas de développer davantage. Nous prévoyons un article plus complet, sans doute en ligne.

Tous les documents issus d’EVAPM viennent d’être rassemblés, par étude, sur le site de l’APMEP :

-

la présentation de l’étude ;

-

la brochure APMEP présentant les résultats et les analyses ;

-

les questionnaires passés par les élèves ;

-

les données brutes recueillies après l’évaluation.

On y trouve aussi la liste des contributeurs à EVAPM ainsi qu’un ensemble d’articles publiés à son propos (auteurs divers). Enfin les renvois aux fiches Publimath sont faits systématiquement.

De son côté, EVAPMIB, la base multicritère développée essentiellement par François Couturier et François Pétiard, qui contient près de questions créées ou utilisées par EVAPM, ou provenant d’autres études à grande échelle, est en cours de révision.

Références

- T. Rocher et B. Troseille. Les évaluations standardisées des élèves, perspective historique. Éducation Formations. N 86-87. Ministère de l’éducation nationale, 2015.↩

- EVAPM.

- EVAPMIB.

- PUBLIMATH.

- Site personnel (voir la page Observatoire EVAPM).

⋅⋅⋅⋅⋅⋅⋅⋅⋅⋅♦⋅⋅⋅⋅⋅⋅⋅⋅⋅⋅

Antoine Bodin est enseignant, chercheur, formateur, retraité depuis 2002. Aujourd’hui consultant international en matière de curriculum et d’évaluation dans le domaine des mathématiques, il a été responsable de l’Observatoire EVAPM de 1986 à 2005.

-

La COPREM, Commission Permanente de Réflexion sur l’Enseignement des Mathématiques, a fonctionné de 1983 à 1986 sous la présidence de Jean Martinet. Henri Bareil, figure de l’APMEP, en fut un membre très influent. Près de quarante ans plus tard, après avoir vécu tous les avatars qui ont suivi, la qualification de permanente a, malheureusement, de quoi faire sourire !

-

DLC : Direction des Lycées et Collèges ; DGESCO : Direction Générale de l’Enseignement SCOlaire.

-

Les frais d’inscription, d’environ 25 € par classe (en 2002), ne couvraient qu’imparfaitement les frais engagés. Les professeurs participant à une opération EVAPM parvenaient en général à obtenir ces fonds sur les crédits pédagogiques de leur établissement.

-

Les lignes ci-dessus sont extraites de la brochure qui a été envoyée personnellement à tous les professeurs ayant participé à l’étude et qui a été largement diffusée (brochure 88 de l’APMEP, 190 pages, accessible en ligne

).

-

Aujourd’hui, DEPP (Direction de l’Évaluation, de la Prospective et de la Performance), anciennement SIGES, puis SPRESE (Service de la PRévision, des Statistiques et de l’Évaluation), puis DEP.

-

Comme en témoigne l’obstination actuelle à vouloir supprimer le CNESCO (Conseil National de l’Évaluation Scolaire).

-

Le mot « confiance » n’existait pas encore. Bel exemple du fait qu’insister comme aujourd’hui sur le mot risque bien de tuer la chose !